Am Samstag wurde Oleksandr Tomchuk, CEO von Triplegangers, darüber informiert, dass die E-Commerce-Website seines Unternehmens nicht verfügbar sei. Es schien sich um eine Art verteilten Denial-of-Service-Angriff zu handeln.

Bald stellte er fest, dass der Übeltäter ein OpenAI-Bot war, der unermüdlich versuchte, seine gesamte riesige Website zu kopieren.

„Wir haben über 65.000 Produkte, jedes Produkt hat eine Seite“, sagte Tomchuk gegenüber TechCrunch. „Jede Seite enthält mindestens drei Fotos.“

OpenAI schickte „Zehntausende“ Serveranfragen, um alles herunterzuladen, Hunderttausende Fotos, zusammen mit ihren detaillierten Beschreibungen.

„OpenAI hat 600 IPs verwendet, um Daten zu sammeln, und wir sehen uns immer noch die Protokolle der letzten Woche an, vielleicht sind es noch viel mehr“, sagte er über die IP-Adressen, mit denen der Bot versuchte, seine Website zu konsumieren.

„Ihre Tracker haben unsere Website zerstört“, sagte er. „Im Grunde war es ein DDoS-Angriff.“

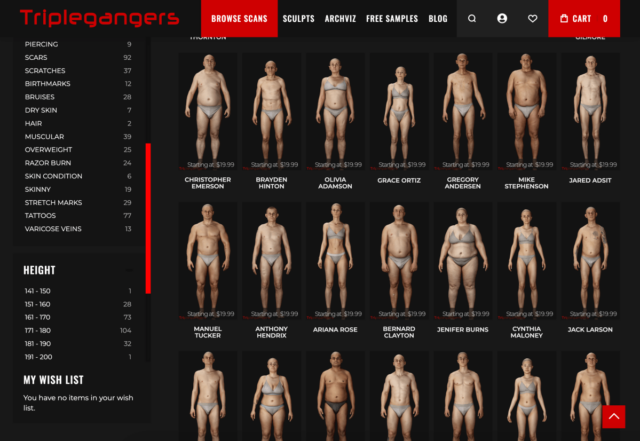

Die Triplegangers-Website ist Ihr Unternehmen. Das Unternehmen mit sieben Mitarbeitern hat mehr als ein Jahrzehnt damit verbracht, die seiner Meinung nach größte Datenbank „menschlicher digitaler Doppelgänger“ im Internet aufzubauen, 3D-Bilddateien, die von echten menschlichen Modellen gescannt wurden.

Es verkauft Dateien von 3D-Objekten sowie Fotos – von Händen über Haare, Haut bis hin zu ganzen Körpern – an 3D-Künstler, Videospielentwickler und alle, die authentische menschliche Merkmale digital nachbilden müssen.

Tomchuks Team, das seinen Sitz in der Ukraine hat, aber auch in den USA in Tampa, Florida, lizenziert ist, hat eine Seite mit den Nutzungsbedingungen auf seiner Website, die Bots verbietet, Ihre Bilder ohne Erlaubnis aufzunehmen. Aber das allein hat nichts gebracht. Websites müssen eine ordnungsgemäß konfigurierte robot.txt-Datei mit Tags verwenden, die den Bot von OpenAI, GPTBot, ausdrücklich anweisen, die Website in Ruhe zu lassen. (OpenAI hat auch einige andere Bots, ChatGPT-User und OAI-SearchBot, die ihre eigenen Tags haben, entsprechend Ihrer Informationsseite in Ihren Trackern.)

Robot.txt, auch bekannt als Robot Exclusion Protocol, wurde erstellt, um Suchmaschinen-Websites mitzuteilen, was sie nicht crawlen sollen, während sie das Web indizieren. OpenAI gibt auf seiner Informationsseite an, dass es diese Dateien respektiert, wenn es mit seinen eigenen Do-Not-Track-Tags konfiguriert ist, warnt jedoch auch, dass es bis zu 24 Stunden dauern kann, bis seine Bots eine aktualisierte robot.txt-Datei erkennen.

Wie Tomchuk erfahren hat, verstehen OpenAI und andere, wenn eine Website robot.txt nicht korrekt verwendet, dies so, dass sie so viel scrapen können, wie sie wollen. Es handelt sich nicht um ein Opt-in-System.

Erschwerend kommt hinzu, dass Triplegangers nicht nur während der US-Geschäftszeiten vom OpenAI-Bot abgeschaltet wurde, sondern Tomchuk erwartet auch eine höhere AWS-Rechnung aufgrund der gesamten CPU- und Download-Aktivität des Bots.

Robot.txt ist auch nicht narrensicher. KI-Unternehmen halten sich freiwillig daran. Ein weiteres KI-Startup, Perplexity, wurde letzten Sommer durch eine Wired-Untersuchung zum Erliegen gebracht als einige Beweise darauf hindeuteten, dass Perplexity dies nicht war das zu würdigen.

Ich kann nicht sicher wissen, was genommen wurde

Am Mittwoch, Tage nach der Rückkehr des OpenAI-Bots, verfügte Triplegangers über eine korrekt konfigurierte robot.txt-Datei und auch über ein Cloudflare-Konto, das seinen GPTBot und mehrere andere von ihm entdeckte Bots blockierte, wie Barkrowler (ein SEO-Crawler) und Bytespider (TokTok Tracker). . Tomchuk hofft auch, dass er Tracker von anderen KI-Modellunternehmen blockiert hat. Bis Donnerstagmorgen sei die Seite nicht abgestürzt, sagte er.

Aber Tomchuk hat immer noch keine vernünftige Möglichkeit, genau herauszufinden, was OpenAI erfolgreich erhalten hat, oder dieses Material zu entfernen. Er fand keine Möglichkeit, OpenAI zu kontaktieren und nachzufragen. OpenAI antwortete nicht auf die Bitte von TechCrunch um einen Kommentar. Und OpenAI hat es bisher getan hat es versäumt, sein seit langem versprochenes Stornierungstool zu liefernwie TechCrunch kürzlich berichtete.

Dies ist eine besonders knifflige Frage für Dreifachgänger. „Wir sind in einem Geschäft tätig, in dem Rechte ein ernstes Problem darstellen, weil wir echte Menschen digitalisieren“, sagte er. Mit Gesetzen wie der europäischen DSGVO „können sie nicht einfach ein Foto von irgendjemandem im Internet machen und es verwenden.“

Auch für KI-Tracker war die Triplegangers-Website ein besonders reizvoller Fund. Multimilliarden-Dollar-Startups wie Scale AIwurden erstellt, bei der Menschen Bilder akribisch markieren, um die KI zu trainieren. Die Triplegangers-Website enthält Fotos mit detaillierten Tags: ethnische Zugehörigkeit, Alter, Tätowierungen versus Narben, alle Körpertypen und so weiter.

Die Ironie besteht darin, dass es die Gier des OpenAI-Bots war, die Triplegangers darauf aufmerksam machte, wie exponiert er war. Wenn er sich sorgfältiger rasiert hätte, hätte Tomtschuk es nie erfahren, sagte er.

„Es ist beängstigend, denn es scheint eine Lücke zu geben, die diese Unternehmen zur Datenverfolgung nutzen und die besagt: „Sie können sich abmelden, wenn Sie Ihre robot.txt-Datei mit unseren Tags aktualisieren“, sagt Tomchuk, aber das legt dem Geschäftsinhaber die Pflicht auf, dies zu tun verstehen, wie man sie blockiert.

Er möchte, dass andere kleine Online-Unternehmen wissen, dass die einzige Möglichkeit, herauszufinden, ob ein KI-Bot urheberrechtlich geschützte Besitztümer einer Website stiehlt, darin besteht, aktiv nachzuschauen. Er ist sicherlich nicht der Einzige, der von ihnen terrorisiert wird. Besitzer anderer Websites sagten kürzlich Geschäftsinsider wie OpenAI-Bots Ihre Websites zum Absturz brachten und Ihre AWS-Rechnungen in die Höhe trieben.

Das Problem hat im Jahr 2024 an Ausmaß zugenommen. Neue Studie des digitalen Werbeunternehmens DoubleVerify entdeckte, dass KI-Tracker und Scraper verursachten im Jahr 2024 einen Anstieg des „allgemein ungültigen Datenverkehrs“ um 86 % – also Datenverkehr, der nicht von einem echten Benutzer stammt.

Dennoch „haben die meisten Websites keine Ahnung, dass sie von diesen Bots kopiert wurden“, warnt Tomchuk. „Jetzt müssen wir die Protokollaktivität täglich überwachen, um diese Bots zu erkennen.“

Wenn man darüber nachdenkt, funktioniert das ganze Modell ein bisschen wie Mafia-Erpressung: Die KI-Bots nehmen sich, was sie wollen, es sei denn, man hat Schutz.

„Sie sollten um Erlaubnis bitten und nicht nur Daten sammeln“, sagt Tomchuk.