Jensen Huang, CEO von Nvidia, sagt, dass die Leistung der KI-Chips seines Unternehmens schneller zunimmt als die historischen Raten, die durch das Mooresche Gesetz festgelegt wurden, die Rubrik, die den Computerfortschritt seit Jahrzehnten vorantreibt.

„Unsere Systeme schreiten viel schneller voran als das Mooresche Gesetz“, sagte Huang am Dienstag, dem Morgen danach, in einem Interview mit TechCrunch hielt auf der CES einen Vortrag vor 10.000 Zuschauern in Las Vegas.

Das 1965 von Intel-Mitbegründer Gordon Moore geprägte Mooresche Gesetz sagte voraus, dass sich die Anzahl der Transistoren auf Computerchips jedes Jahr etwa verdoppeln würde, was im Wesentlichen zu einer Verdoppelung der Leistung dieser Chips führen würde. Diese Vorhersage erwies sich als erfolgreich und führte über Jahrzehnte zu raschen Kapazitätssteigerungen und starken Kostenrückgängen.

In den letzten Jahren hat sich das Mooresche Gesetz verlangsamt. Huang behauptet jedoch, dass die KI-Chips von Nvidia in ihrem eigenen rasanten Tempo voranschreiten; Das Unternehmen behauptet, sein neuester Rechenzentrums-Superchip sei bei der Ausführung von KI-Inferenz-Workloads 30-mal schneller als seine Vorgängergeneration.

„Wir können die Architektur, den Chip, das System, die Bibliotheken und die Algorithmen gleichzeitig bauen“, sagte Huang. „Wenn Sie das tun, können Sie schneller vorankommen als Moores Gesetz, weil Sie über den gesamten Stack hinweg Innovationen hervorbringen können.“

Die kühne Aussage des CEO von Nvidia kommt zu einem Zeitpunkt Viele fragen sich, ob der KI-Fortschritt stagniert hat. Top-KI-Labore – wie Google, OpenAI und Anthropic – verwenden die KI-Chips von Nvidia, um ihre KI-Modelle zu trainieren und auszuführen, und Fortschritte bei diesen Chips würden wahrscheinlich zu größeren Fortschritten bei den Fähigkeiten der KI-Modelle führen.

Dies ist nicht das erste Mal, dass Huang behauptet, dass Nvidia über Moores Gesetz hinausgeht. In einem Podcast im NovemberHuang schlug vor, dass die Welt der KI auf dem Weg zum „Hyper-Mooreschen Gesetz“ sei.

Huang lehnt die Vorstellung ab, dass sich der KI-Fortschritt verlangsamt. Stattdessen behauptet er, dass es mittlerweile drei aktive Gesetze der KI-Skalierung gibt: Pre-Training, die anfängliche Trainingsphase, in der KI-Modelle Muster aus großen Datenmengen lernen; Post-Training, das die Reaktionen eines KI-Modells mithilfe von Methoden wie menschlichem Feedback anpasst; und die Testzeitberechnung, die während der Inferenzphase erfolgt und dem KI-Modell nach jeder Frage mehr Zeit zum „Nachdenken“ gibt.

„Moores Gesetz war in der Geschichte der Informatik so wichtig, weil es die Rechenkosten senkte“, sagte Huang gegenüber TechCrunch. „Das Gleiche wird mit Inferenz passieren, wo wir die Leistung steigern und dadurch die Kosten für Inferenz niedriger werden.“

(Natürlich hat Nvidia hat sich zum wertvollsten Unternehmen der Welt entwickelt den KI-Boom ausnutzen, daher ist es für Huang von Vorteil, dies zu sagen.)

Nvidias H100s waren der Chip der Wahl für Technologieunternehmen, die KI-Modelle trainieren wollten, aber jetzt, da sich Technologieunternehmen mehr auf Inferenz konzentrieren, Einige fragen sich, ob die teuren Chips von Nvidia weiterhin an der Spitze bleiben werden.

KI-Modelle, die Testzeit-Computing verwenden, sind heute teuer in der Ausführung. Es besteht die Sorge, dass das o3-Modell von OpenAI, das eine erweiterte Version des Testzeit-Computings verwendet, für die meisten Menschen zu teuer sein wird. Zum Beispiel, OpenAI gab für die Verwendung von o3 fast 20 US-Dollar pro Aufgabe aus, um Ergebnisse auf menschlicher Ebene zu erhalten bei einem allgemeinen Intelligenztest. Ein ChatGPT Plus-Abonnement kostet 20 US-Dollar für einen ganzen Nutzungsmonat.

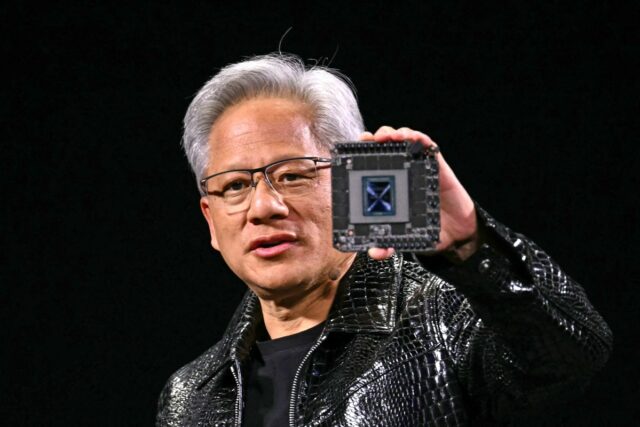

Huang hielt Nvidias neuesten Rechenzentrums-Superchip, den GB200 NVL72, während der Keynote am Montag wie einen Schutzschild auf die Bühne. Dieser Chip ist bei der Ausführung von KI-Inferenz-Workloads 30- bis 40-mal schneller als der bisher meistverkaufte Chip von Nvidia, der H100. Laut Huang bedeutet dieser Leistungssprung, dass KI-Schlussfolgerungsmodelle wie o3 von OpenAI, das während der Inferenzphase eine erhebliche Menge an Rechenleistung verbraucht, mit der Zeit billiger werden.

Huang sagt, er konzentriere sich auf die Entwicklung leistungsstärkerer Chips und dass leistungsstärkere Chips langfristig zu niedrigeren Preisen führen.

„Die direkte und unmittelbare Lösung für Testzeit-Computing, sowohl hinsichtlich der Leistung als auch der Erschwinglichkeit, besteht darin, unsere Rechenkapazität zu erhöhen“, sagte Huang gegenüber TechCrunch. Er wies darauf hin, dass KI-Argumentationsmodelle langfristig genutzt werden könnten, um bessere Daten für KI-Modelle vor und nach dem Training zu erstellen.

Wir haben im letzten Jahr sicherlich einen Preisverfall bei KI-Modellen erlebt, der zum Teil auf die Rechenfortschritte von Hardware-Unternehmen wie Nvidia zurückzuführen ist. Huang sagt, dass dies ein Trend ist, von dem er erwartet, dass er sich bei KI-Argumentationsmodellen fortsetzt, obwohl die ersten Versionen von OpenAI, die wir gesehen haben, recht teuer waren.

Im weiteren Sinne sagte Huang, dass seine KI-Chips heute 1.000-mal besser seien als die vor 10 Jahren hergestellten. Das ist ein viel schnelleres Tempo als der durch das Mooresche Gesetz festgelegte Standard, und Huang sagt, er sehe keine Anzeichen dafür, dass er bald damit aufhört.