Amazon Web Services (AWS), die Cloud-Computing-Abteilung von Amazon, bringt ein neues Tool zur Bekämpfung auf den Markt Halluzinationen – also Szenarien, in denen sich ein KI-Modell unzuverlässig verhält.

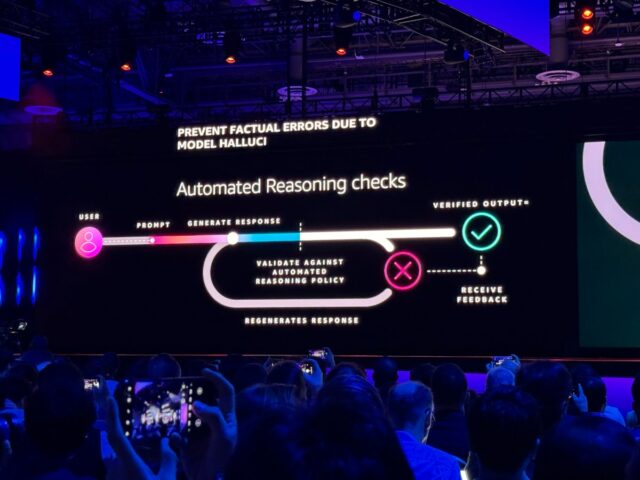

Angekündigt in AWS re:Invent 2024-Konferenz In Las Vegas validiert der Dienst „Automated Reasoning Checks“ die Antworten eines Modells, indem er die vom Kunden bereitgestellten Informationen mit Querverweisen vergleicht, um die Genauigkeit zu ermitteln. AWS gibt in einer Pressemitteilung an, dass automatisierte Argumentationsprüfungen der „erste“ und „einzige“ Schutz vor Halluzinationen seien.

Aber das ist, nun ja … großzügig ausgedrückt.

Automatisierte Argumentationsprüfungen sind nahezu identisch mit Korrektur Diesen Sommer hat Microsoft eine Funktion eingeführt, die auch KI-generierten Text kennzeichnet, der möglicherweise sachlich falsch ist. Google auch Angebote ein Tool in Vertex AI, seiner KI-Entwicklungsplattform, mit dem Kunden Modelle anhand von Daten von Drittanbietern, ihren eigenen Datensätzen oder der Google-Suche „basieren“ können.

In jedem Fall die automatisierten Argumentationsprüfungen, die über AWS verfügbar sind Grundgestein Der Modell-Hosting-Dienst (insbesondere das Guardrails-Tool) versucht herauszufinden, wie ein Modell zu einer Antwort gelangt ist – und festzustellen, ob die Antwort richtig ist. Kunden laden Informationen hoch, um eine Art Wahrheit festzustellen, und automatisierte Argumentationsprüfungen erstellen Regeln, die verfeinert und auf ein Modell angewendet werden können.

Während ein Modell Antworten generiert, überprüft Automated Reasoning diese und verlässt sich im Falle einer wahrscheinlichen Halluzination auf die Wahrheit, um die richtige Antwort zu erhalten. Es präsentiert diese Antwort zusammen mit der wahrscheinlichen Unwahrheit, damit Kunden erkennen können, wie weit das Modell möglicherweise von der Basis abweicht.

Laut AWS nutzt PwC bereits automatisierte Argumentationsprüfungen, um KI-Assistenten für seine Kunden zu entwickeln. Und Swami Sivasubramanian, Vizepräsident für KI und Daten bei AWS, meinte, dass diese Art von Tools genau das sind, was Kunden zu Bedrock lockt.

„Mit der Einführung dieser neuen Funktionen“, sagte er in einer Erklärung, „entwickeln wir im Auftrag unserer Kunden Innovationen, um einige der wichtigsten Herausforderungen zu lösen, mit denen die gesamte Branche bei der Einführung generativer KI-Anwendungen in die Produktion konfrontiert ist.“ Der Kundenstamm von Bedrock sei im vergangenen Jahr um das 4,7-fache auf Zehntausende Kunden gewachsen, fügte Sivasubramanian hinzu.

Aber wie mir ein Experte diesen Sommer sagte, ist der Versuch, Halluzinationen durch generative KI zu beseitigen, wie der Versuch, Wasserstoff aus Wasser zu entfernen.

KI-Modelle halluzinieren, weil sie eigentlich nichts „wissen“. Hierbei handelt es sich um statistische Systeme, die Muster in einer Reihe von Daten erkennen und anhand zuvor gesehener Beispiele vorhersagen, welche Daten als nächstes folgen werden. Daraus folgt, dass die Antworten eines Modells keine Antworten sind, sondern Vorhersagen darüber, wie die Fragen gestellt werden er muss beantwortet werden – innerhalb von a Fehlerquote.

AWS gibt an, dass automatisierte Argumentationsprüfungen „logisch korrektes Denken“ und „überprüfbares Denken“ verwenden, um zu ihren Schlussfolgerungen zu gelangen. Das Unternehmen hat jedoch keine Daten vorgelegt, die belegen, dass das Tool zuverlässig ist.

In anderen Bedrock-Nachrichten kündigte AWS heute Morgen Model Distillation an, ein Tool zum Übertragen der Ressourcen eines großen Modells (z. B. Rufen Sie 405B an) für ein kleines Modell (z.B. Rufen Sie 8B an), was kostengünstiger und schneller auszuführen ist. Eine Antwort an Microsoft Destillation in Azure AI FoundryLaut AWS bietet Model Distillation eine Möglichkeit, mit mehreren Modellen zu experimentieren, ohne die Bank zu sprengen.

„Nachdem der Kunde Beispielaufforderungen bereitgestellt hat, übernimmt Amazon Bedrock die gesamte Arbeit, um Antworten zu generieren und das kleinere Modell zu optimieren“, erklärte AWS in einem Blogbeitrag, „und kann bei Bedarf sogar weitere Beispieldaten erstellen, um den Destillationsprozess abzuschließen.“

Es gibt jedoch einige Vorbehalte.

Derzeit funktioniert Model Distillation nur mit von Bedrock gehosteten Modellen von Anthropic und Meta. Kunden müssen ein großes und ein kleines Modell aus derselben Modell-„Familie“ auswählen – Modelle dürfen nicht von unterschiedlichen Anbietern sein. Und destillierte Modelle werden etwas an Genauigkeit verlieren – „weniger als 2 %“, sagt AWS.

Wenn Sie das alles nicht aufhält, ist die Modelldestillation jetzt in der Vorschau verfügbar, zusammen mit automatischen Argumentationsprüfungen.

Ebenfalls in der Vorschau verfügbar ist „Multi-Agent Collaboration“, eine neue Funktion von Bedrock, die es Kunden ermöglicht, Teilaufgaben innerhalb eines größeren Projekts KI zuzuweisen. Ein Teil von Grundlegende AgentenDer Beitrag von AWS zum Der Hype um KI-AgentenDie Zusammenarbeit mehrerer Agenten bietet Tools zum Erstellen und Optimieren von KI für Dinge wie die Überprüfung von Finanzunterlagen und die Bewertung globaler Trends.

Kunden können sogar einen „Supervising Agent“ benennen, der Aufgaben automatisch aufteilt und an KIs weiterleitet. Der Vorgesetzte kann „bestimmten Agenten Zugriff auf die Informationen gewähren, die sie zur Erledigung ihrer Arbeit benötigen“, sagt AWS, und „bestimmen“, welche Aktionen parallel verarbeitet werden können und welche Details aus anderen Aufgaben benötigen, bevor (ein) Agent dies kann vorwärts gehen.“

„Nachdem alle Experten (KIs) ihre Eingaben abgeschlossen haben, kann der überwachende Agent die Informationen sammeln (und) die Ergebnisse synthetisieren“, schrieb AWS in dem Beitrag.

Es sieht cool aus. Aber wie bei all diesen Funktionen müssen wir sehen, wie gut es funktioniert, wenn es in der realen Welt eingesetzt wird.